Скоро за човека няма да остане никакво място, което е само лично негово пространство. Дори мислите ни и разговорите, които водим със себе си или въображаем партньор, вече ще могат да бъдат декодирани от мозъчен скенер. Изследователи са разработили първия неинвазивен метод за определяне на същността на въображаемата реч, представяйки възможно решение за комуникация на хора, които не могат да говорят. Това беше описано като стъпка към четенето на мисли, предаде БГНЕС, като цитира АФП. Но колко близо е технологията до истинското четене на мисли? И как политиците могат да гарантират, че с подобни разработки няма да се злоупотребява?

Скоро за човека няма да остане никакво място, което е само лично негово пространство. Дори мислите ни и разговорите, които водим със себе си или въображаем партньор, вече ще могат да бъдат декодирани от мозъчен скенер. Изследователи са разработили първия неинвазивен метод за определяне на същността на въображаемата реч, представяйки възможно решение за комуникация на хора, които не могат да говорят. Това беше описано като стъпка към четенето на мисли, предаде БГНЕС, като цитира АФП. Но колко близо е технологията до истинското четене на мисли? И как политиците могат да гарантират, че с подобни разработки няма да се злоупотребява?

- "Кръстникът" на изкуствения интелект: Скоро той ще е по-умен от хората

- AI се учи от опита, както прави човек, но споделя знанията си незабавно с всички себеподобни

Повечето съществуващи технологии за привеждане на мисъл към говор използват мозъчни импланти, които наблюдават активността в моторния кортекс на човека и предсказват думите, които устните се опитват да формират. За да разберат действителното значение зад тази мисъл, неврологът Александър Хът и компютърният специалист Джери Танг от Тексаския университет в Остин са комбинирали функционален магнитен резонанс (fMRI), неинвазивно средство за измерване на мозъчната активност, с алгоритми с изкуствен интелект, наречени големи езикови модели (LLM), които са в основата на инструменти като ChatGPT и са обучени да предвиждат следващата дума в част от текста.

В проучване, публикувано в Nature Neuroscience на 1 май, изследователите карат трима доброволци да лежат в fMRI скенер и записват мозъчната им активност, докато слушат 16 часа подкасти. Чрез измерване на притока на кръв през мозъците на доброволците и интегриране на тази информация с подробности за историите, които са слушали и способността на изкуствения интелект да разбере как думите се свързват една с друга, изследователите разработват кодирана карта за това как мозъкът на всеки индивид реагира на различни думи и фрази.

След това записват дейността на участниците с fMRI, докато слушат история, представят си как разказват история или гледат филм, който не съдържа диалог. Използвайки комбинация от моделите, които преди това са кодирали за всеки индивид, и алгоритми, които определят как едно изречение вероятно ще бъде конструирано въз основа на други думи в него, изследователите се опитват да декодират тази нова мозъчна дейност.

- Попадения и пропуски

Декодерът генерира изречения, които разбират същността на това, което човекът мисли. Фразата "Все още нямам шофьорска книжка", например, е декодирана като "Тя дори още не е започнала да се учи да шофира". Технологията върши доста точна работа и в описването на това, което хората виждат във филмите. Но много от изреченията са били неточни.

Изследователите установили, че е лесно да се излъже технологията. Когато участниците мислят за различни неща, докато слушат записана история, декодерът не може да определи думите, които чува. Кодираната карта също се различава между отделните индивиди, което означава, че изследователите не могат да създадат един декодер, който да работи за всички.

Но дори когато участниците измисляли свои собствени истории, или гледали неми филми, декодерът все пак успявал да схване "същността", казват изследователите. Това показва, че "ние декодираме нещо, което е по-дълбоко от езика, и след това го превръщаме в език", казва Хът.

- Кой ще защити личният ни живот?

Макар че основната цел на езиковия декодер е да помогне на хора, които са загубили способността си да общуват, американските учени признават, че технологията повдига въпроси за "неприкосновеността на личния живот". За да успокоят тези опасения, те проведоха тестове, които показаха, че техният декодер не може да бъде използван от лица, които не са позволили той да бъде обучен на мозъчната им дейност в продължение на дълги часове в скенер за функционален магнитен резонанс (фМР).

Това е първата система, която може да реконструира непрекъснат език без инвазивен мозъчен имплант, според проучването в списание Nature Neuroscience.

Давид Родригес-Ариас Вайлен, професор по биоетика в испанския университет в Гранада, който не е участвал в изследването, заяви, че то надхвърля постигнатото от предишни мозъчно-компютърни интерфейси. Това ни доближава до бъдещето, в което машините "ще могат да четат и да преписват мисли", каза той, като предупреди, че това може да се случи против волята на хората, например когато те спят.

Изследователският екип се надява да ускори процеса, за да може да декодира мозъчните сканирания в реално време. Учените призоваха и за правила за защита на личния живот на психично болните. "Досега нашият ум е бил пазител на личния ни живот", каза биоетикът Родригес-Ариас Вайлен. "Това откритие може да бъде първата стъпка към компрометиране на тази свобода в бъдеще".

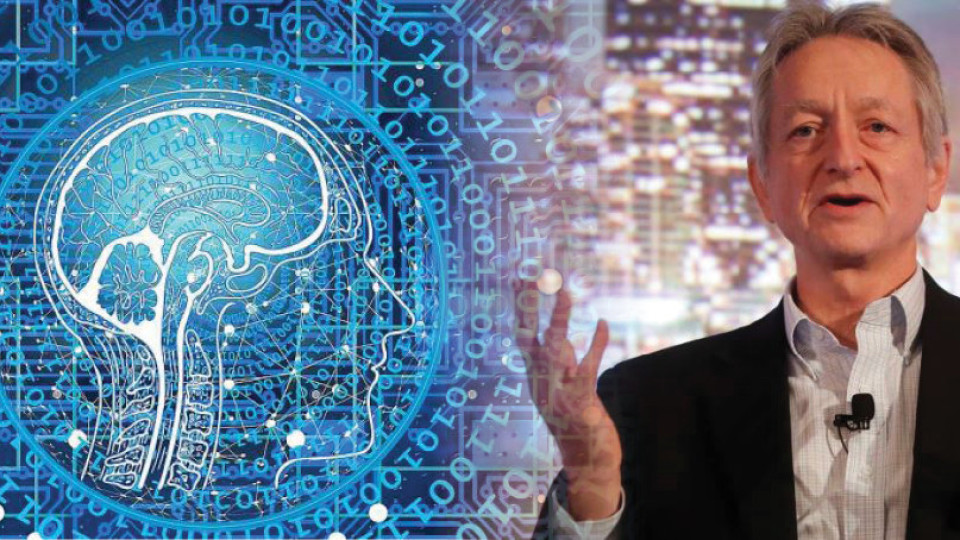

- AI гуруто д-р Джефри Хинтън съжалява за работата си

75-годишният д-р Джефри Хинтън, известен като "Кръстникът" на изкуствения интелект, подаде оставката си от компанията Гугъл. В изявление за New York Times той каза, че вече може да говори свободно и сега съжалява за работата си. Той обясни, че някои от опасностите от чатботовете с изкуствен интелект (AI) са "доста страшни". "В момента те не са по-интелигентни от нас, доколкото мога да преценя. Но мисля, че скоро може да са." Пионерските изследвания на д-р Хинтън върху невронните мрежи и т.нар. "дълбоко обучение" проправиха пътя за настоящите AI системи, като ChatGPT. В областта на изкуствения интелект невронните мрежи са системи, които са подобни на човешкия мозък по начина, по който учат и обработват информация. Те позволяват на AI да се учат от опита, както би направил човек. Това се нарича дълбоко обучение.

Британско-канадският когнитивен психолог и компютърен учен каза пред BBC, че чатботовете скоро могат да надминат нивото на информация, което човешкият мозък притежава.

"В момента това, което виждаме, е, че неща като GPT-4 засенчват човек по отношение на общите познания, които има, и то много. От гледна точка на разсъждаването обаче не е толкова добър, но вече прави прости разсъждения. И като се има предвид темпът на напредък, очакваме нещата да се подобрят доста бързо. Така че трябва да се тревожим за това," каза ученият.

Пред New York Times д-р Хинтън говори за "лоши актьори", които биха се опитали да използват AI за "лоши неща". Когато е помолен да разясни това свое твърдение, той отговаря: "Това е просто един вид най-лош сценарий. Можете да си представите, например, ако някой лош актьор, като руския президент Владимир Путин, реши да даде на роботите способността да създават свои собствени подцели." Ученият предупреждава, че това може "да създаде подцели като например: "Трябва да получа повече сила". "Стигнах до извода, че видът интелект, който развиваме, е много различен от интелекта, който имаме. Ние сме биологични системи, а това са цифрови системи. И голямата разлика е, че с цифровите системи имате много копия на един и същ модел на света. И всички тези копия могат да учат поотделно, но да споделят знанията си незабавно. Така че все едно имате 10 000 души и всеки път, когато един човек научи нещо, всички автоматично го знаят. Това е начинът, по който тези чатботове могат да знаят много повече от всеки един човек".

Д-р Хинтън се присъединява към нарастващия брой експерти, които изразяват загриженост относно AI - както за скоростта, с която се развива, така и за посоката, в която върви. През март отворено писмо, подписано от десетки специалисти в областта на изкуствения интелект, включително технологичния милиардер Илон Мъск, призова за спиране на всички разработки, които са по-напреднали от текущата версия на чатбота ChatGPT, така че да могат да бъдат проектирани стабилни мерки за безопасност и да бъдат изпълнени. Йошуа Бенгио, друг така наречен кръстник на AI, който заедно с д-р Хинтън и Ян Лекун спечелиха наградата "Тюринг" през 2018 г. за работата си по задълбочено обучение, също подписа писмото.

Последвайте ни в Google News Showcase за важните новини

Вижте всички актуални новини от Standartnews.com